Seit einigen Wochen besitze ich meinen ersten FDM-3D-Drucker und ich bin wirklich begeistert. Der Drucker bietet ein super Preis-Leistungs-Verhältnis und ist optimal für Einsteiger geeignet. Bei Hartware habe ich einen ausführlichen Testbericht über den Elegoo Neptune 3 Plus verfasst. Auch den Elegoo Neptune 3 Pro habe ich mittlerweile getestet.

Da der Neptune 3 Pro / Plus / Max bis auf die Größe quasi identisch sind, können die beschriebenen Schritte eins zu eins für alle drei Modelle angewendet werden.

Nach dem Aufbau und ein paar grundlegenden Vorarbeiten könnt ihr direkt mit dem ersten Druck starten. Wer bereits mehr Erfahrung im 3D-Druck besitzt, möchte oftmals aber gerne das Feintuning angehen, bevor der erste Druck gestartet wird. Dadurch kann die von Haus aus bereits gute Druckqualität noch weiter gesteigert werden. Das Feintuning kann aber unabhängig davon zu jeder Zeit durchgeführt werden.

Ebenso sollten die nachfolgend genannten Schritte durchgeführt werden, wenn irgendetwas beim Extruder geändert wird (neues Zahnrad, neuer Extruder, neuer Stepper-Motor, etc.).

Extruder steps/mm kalibrieren

Ein wichtiger Punkt beim FDM-Druck ist sicherzustellen, dass der Extruder tatsächlich die gewünschte Menge an Filament fördert. Im Fachjargon spricht man von “Extruder steps/mm kalibrieren”. Mit diesen Stichworten solltet ihr im Internet diverse ausführliche Anleitungen finden. Ich gehe nur im Schnelldurchlauf darauf ein.

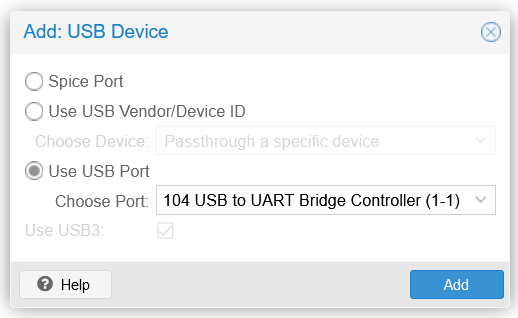

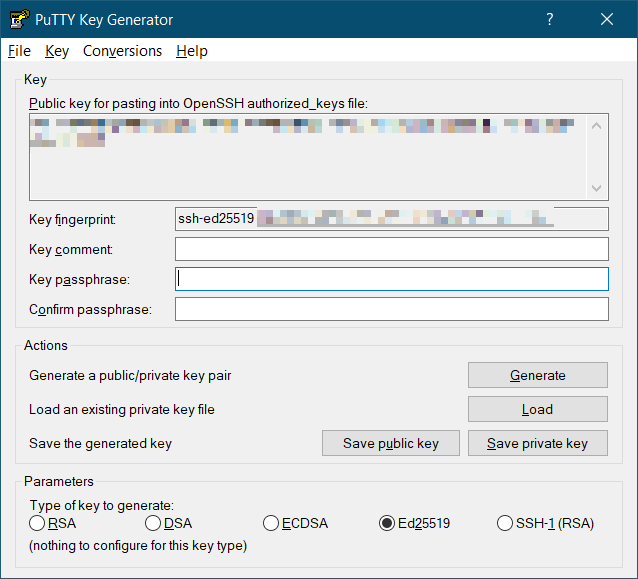

Zunächst muss der 3D-Drucker mit einem PC oder Notebook verbunden werden. Das mitgelieferte USB-Kabel beim Neptune 3 Pro ist mit 50 cm leider sehr kurz. Entweder stellt ihr euer Notebook direkt neben den Drucker oder ihr verwendet ein längeres USB-Kabel bzw. eine USB-Verlängerung. Anschließend kann der auf der microSD-Karte vorhandene USB-Treiber installiert werden. Dieser kann aber auch hier heruntergeladen werden (CH341SER.EXE): http://www.wch-ic.com/downloads/CH341SER_ZIP.html

Ebenso benötigt ihr das Tool “Pronterface”, welches ihr bei Github herunterladen könnt.

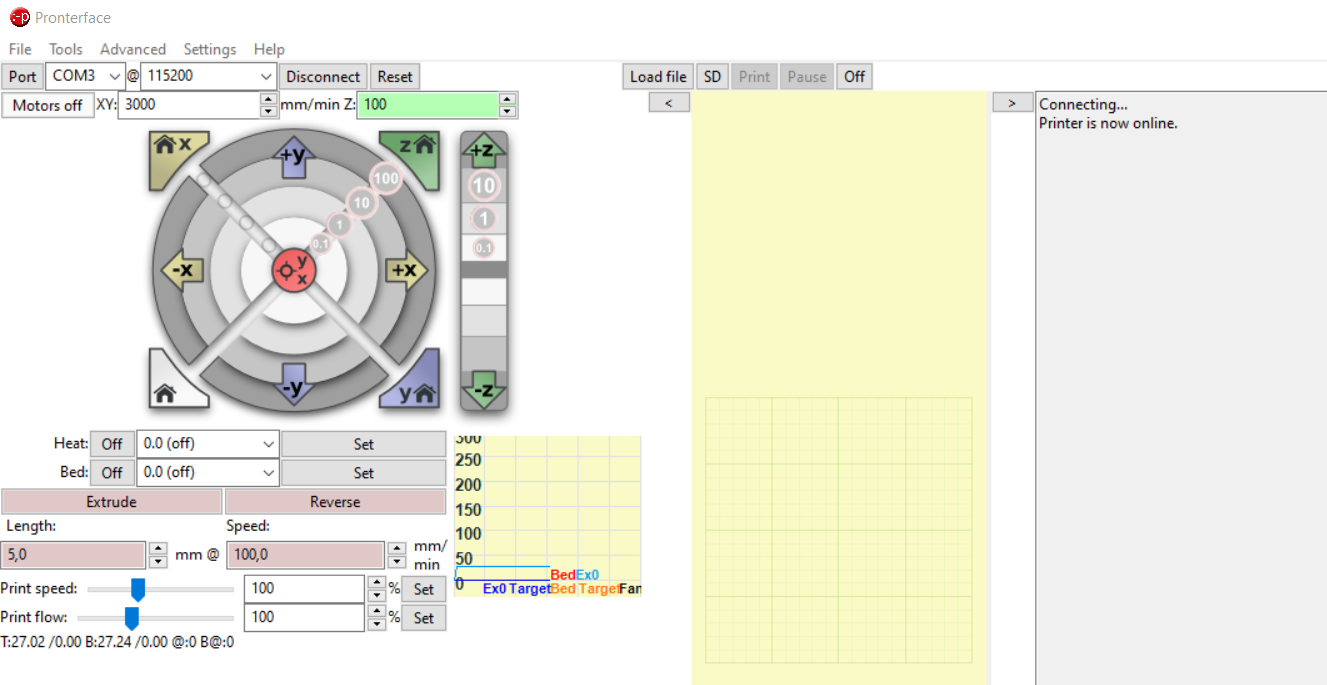

Nach dem Start von Pronterface könnt ihr oben links den richtigen COM-Port auswählen und auf “Connect” klicken.

Anschließend ladet ihr ein Filament eurer Wahl in den Extruder und markiert dann 12 cm. 12 cm nehmen wir deshalb, damit wir auch nachmessen können, wenn zu viel eingezogen wurde. Wenn wir nur 10 cm markieren, würde das nicht funktionieren.

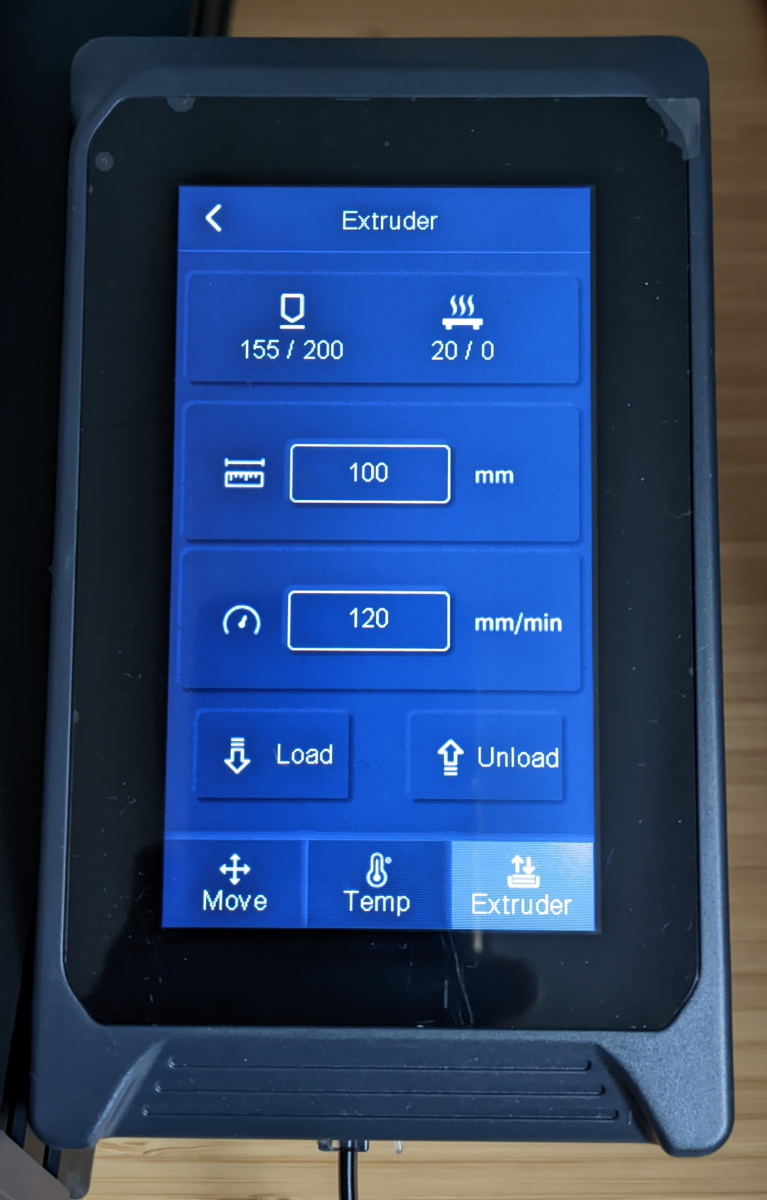

Die Temperatur muss passend zum verwendeten Filament gesetzt werden. Jetzt könnt ihr über den Touchscreen 100 mm extrudieren lassen.

Wenn das erledigt ist, könnt ihr nachmessen, wie viel Filament eingezogen wurde. Wenn es annähernd 10 cm sind (+- 2-3 mm), dann ist alles in Ordnung. Sollten es beispielsweise 9 oder 11 cm gewesen sein, solltet ihr die steps/mm anpassen. Bei mir wurden nur 9,2 cm eingezogen.

Der aktuelle Wert kann via Pronterface mittels des Befehls “M503” ausgelesen werden. Gesucht ist der Wert “M92”. In meinem Fall war das Ergebnis “M92 X80.00 Y80.00 Z400.00 E390.00”. Also 390 Steps. Mit Hilfe des Dreisatzes könnt ihr nun den neuen Wert berechnen: 100 x (alter Wert) / (neuer Wert) = X. In meinem Beispiel also 100 x 390 / 92 = 423,91.

Ich habe auf 424 aufgerundet und den neuen Wert mit dem Befehl “M92 E435” an den Drucker gesendet. Mit “M500” wird alles gespeichert und mit “M503” kann man die Anpassung nochmals überprüfen.

Zum Schluss solltet ihr die genannten Schritte wiederholen und nochmals prüfen, ob jetzt genau 10 cm extrudiert werden.

Temperatur-Tower

Nachdem die hardwareseitige Kalibrierung passt, kommen wir zu den Filament-Einstellungen. Als erstes müssen wir die optimale Drucktemperatur herausfinden. Damit das klappt nutzen wir einen sogenannten Temperatur-Tower. Bei Thingiverse gibt es verschiedene Modelle, wobei sich unter anderem diese Variante mit fertigem GCODE bewährt hat: https://www.thingiverse.com/thing:3912855

Nach dem Druck wählt ihr die am besten aussehende Temperatur. Mit dieser Temperatur werden alle weiteren Schritte durchgeführt. Dabei solltet ihr auf minimales Stringing, ein minimales Durchhängen an Brücken und Überhängen und generell auf ein insgesamt “gutes Aussehen” wert legen.

Flow anpassen

Kommen wir zur Einstellung der Flowrate bzw. Flussrate (in Deutsch). Um die richtige Flowrate herauszufinden, nutzen wir den Würfeltest. Hierzu drucken wir einen 20×20 mm Würfel ohne Infill, ohne Top und Bottom-Layer und mit einer Wandstärke, welche dem doppelten Nozzle-Durchmesser entspricht. Beim Standard-Nozzle mit 0,4 mm drucken wir also zwei Wände mit jeweils 0,4 mm, was dann 0,8 mm ergibt.

Ich nutze immer folgendes Modell: https://www.thingiverse.com/thing:38108

Nach dem Druck wird mit dem Messschieber gemessen. Dabei solltet ihr nicht in der Nähe der Ecken messen, da hier die Werte abweichen können. Des Weiteren sollten auch nicht die ersten paar Schichten mit gemessen werden, Stichwort “Elefantenfuß”. Messt am besten alle vier Wände und bildet dann den Durchschnitt. Sollte der Wert nicht genau 0,8 mm ergeben, müsst ihr entsprechend die Flowrate anpassen. Hier die benötigte Formel:

neue Flowrate = (erwartete Dicke / gemessene Dicke) x (aktuelle Flowrate)

Wenn die Messung also beispielsweise 0,85 mm ergibt, dann lautet die Rechnung so: (0,8 / 0,85) x 100 % = 94,12 %

Den neuen Flow-Wert könnt ihr nur in eurem Slicer eintragen. In Cura befindet sich die entsprechende Einstellung unter “Material”.

Abschließend wird der Würfel mit der angepassten Flussrate erneut gedruckt und gemessen.

PID-Autotuning am Hotend

Eine relativ einfache, aber wirkungsvolle Möglichkeit, die Druckergebnisse zu optimieren ist das sogenannte PID-Autotuning. Das Kalibrierungsverfahren sorgt dafür, dass die Temperatur am Hotend möglichst stabil bleibt und nicht zu stark schwankt.

Der Elegoo Neptune 3 Pro / Plus / Max unterstützen das PID-Autotuning mit der ausgelieferten Firmware allerdings noch nicht. Bevor die Funktion zum Einsatz kommen kann, muss also die Firmware aktualisiert werden. Die jeweils aktuellste Firmware und eine kurze Anleitung findet ihr bei Github:

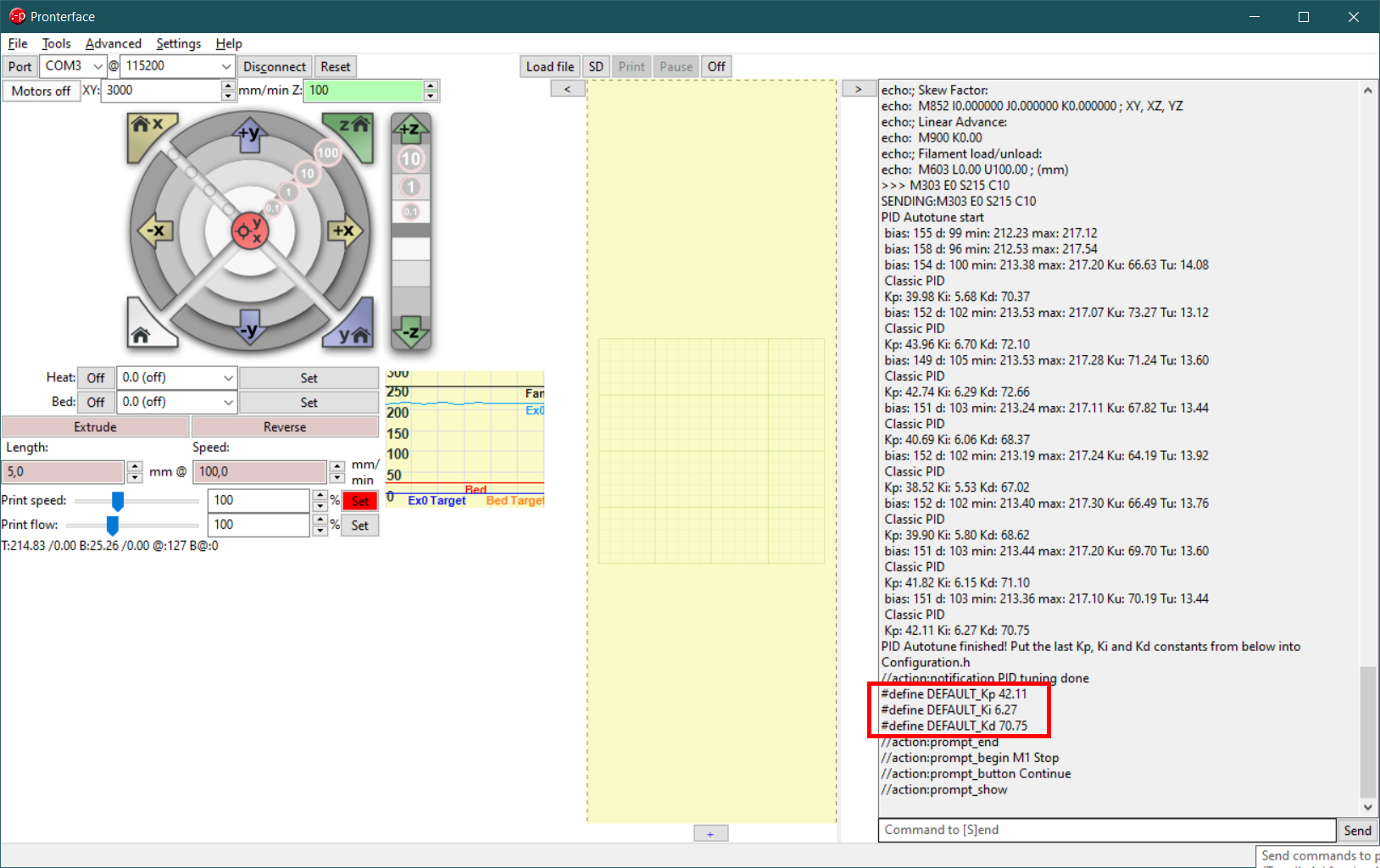

Sobald das erledigt ist, kann das PID-Autotuning starten. Hierzu müsst ihr wieder Pronterface starten und euch mit eurem Drucker verbinden.

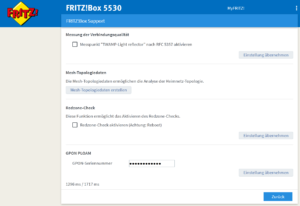

Mit dem Befehl “M503” könnt ihr die aktuelle Einstellung auslesen. Der gesuchte Wert befindet sich bei “M301”. Bei meinem Drucker war “M301 P24.50 I1.80 D79.42” hinterlegt.

Anschließend könnt ihr das PID-Autotuning starten. Die Zieltemperatur sollte im Idealfall die Temperatur sein, mit welcher ihr am häufigsten druckt. Da ich das meiste mit Extrudr NX2 PLA drucke, sind dies bei mir 215 °C. Ebenfalls drucke ich immer mit eingeschaltetem Lüfter, daher sollte das Tuning auch mit Lüfter erfolgen. Also starten wir zunächst den Lüfter mit dem Befehl “M106 E0 S255”. Anschließend kann das Tuning in meinem Beispiel mit dem Befehl “M303 E0 S215 C10” gestartet werden. 10 ist die Anzahl der Heizzyklen. Das Hotend wird jetzt zehnmal auf 215 °C aufgeheizt und wieder abgekühlt. Währenddessen werden die optimalen Werte ermittelt, die am Ende des Tunings ausgegeben werden.

Die drei umrandeten Werte sind die ermittelten Idealwerte. Diese übernehmen wir in den Befehl “M301” und senden diesen ab: M301 P42.11 I6.27 D70.75

Jetzt wird die Konfiguration mit “M500” gespeichert.

Quellen:

- https://www.reddit.com/r/ender3/comments/ec2i9j/how_to_calibrate_your_printers_esteps_and/

- https://drucktipps3d.de/extruder-esteps-kalibrieren/

- https://drucktipps3d.de/fluss-und-linienbreite-einstellen/

Sie sehen gerade einen Platzhalterinhalt von X. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr Informationen

Neueste Kommentare